Thị giác máy (Machine Vision)

Thị Giác Máy Trong Điều Khiển Robot (Robot Guidance): Chìa Khóa Công Nghệ 6DOF Cho Kỷ Nguyên Sản Xuất Linh Hoạt

Thị giác máy trong điều khiển robot (robot guidance) đang chuyển đổi toàn diện cục diện sản xuất công nghiệp, dịch chuyển từ tự động hóa cứng nhắc sang mô hình linh hoạt (Flexible Automation). Công nghệ này cho phép robot công nghiệp không còn bị giới hạn bởi các điểm cố định được lập trình sẵn mà có thể “nhìn” và phản ứng với môi trường thay đổi theo thời gian thực. Bằng cách tích hợp camera 2D hoặc 3D với thuật toán học sâu (Deep Learning), thị giác máy trong điều khiển robot (robot guidance) mang lại khả năng định vị chính xác vị trí và tư thế (pose) của các vật thể ngẫu nhiên, từ đó nâng cao độ chính xác, tốc độ và khả năng thích ứng của robot trong các tác vụ phức tạp như gắp, đặt và lắp ráp.

1. Vai trò Chuyển đổi của Thị giác máy trong Kỷ nguyên Tự động hóa

Trong bối cảnh Tự động hóa 4.0 (Industry 4.0), nhu cầu về các hệ thống robot không chỉ nhanh mà còn phải thông minh và linh hoạt đang trở nên cấp thiết. Robot truyền thống được lập trình bằng phương pháp dạy học thủ công (Teach Pendant) hoạt động dựa trên tọa độ cố định; chúng chỉ có thể thực hiện công việc nếu vật thể luôn nằm ở cùng một vị trí với cùng một tư thế.

Sự thiếu linh hoạt này là một rào cản lớn đối với các dây chuyền sản xuất đa dạng sản phẩm và tốc độ cao. Thị giác máy trong điều khiển robot (robot guidance) đã giải quyết triệt để vấn đề này. Nó định nghĩa lại khả năng của robot bằng cách cung cấp cho chúng “đôi mắt” để nhận biết, phân tích và phản ứng với các vật thể có vị trí và hướng ngẫu nhiên.

Về cơ bản, robot guidance chuyển đổi robot từ một công cụ thực hiện lệnh mù quáng thành một cộng tác viên thông minh có thể tự động điều chỉnh hành vi của mình. Thị giác máy trong điều khiển robot (robot guidance) chính là cầu nối chiến lược, thúc đẩy sự chuyển đổi từ tự động hóa cứng nhắc (Hard Automation) sang tự động hóa linh hoạt (Flexible Automation), nơi mà các robot có thể xử lý các nhiệm vụ phức tạp, không lặp lại và hoạt động trong môi trường không được kiểm soát chặt chẽ như trước.

Tầm quan trọng của công nghệ này là rất lớn, nó quyết định khả năng thích nghi của nhà máy trước sự thay đổi liên tục của thị trường.

2. Định nghĩa và Cơ chế Hoạt động của Hệ thống Robot Guidance

Để hiểu rõ cách thị giác máy trong điều khiển robot (robot guidance) hoạt động, cần nắm vững mô hình tích hợp giữa hệ thống thị giác và hệ thống điều khiển robot. Khái niệm Robot Guidance: Robot Guidance (hay Thị giác hướng dẫn Robot) là công nghệ sử dụng dữ liệu thị giác (visual data) – thu được từ camera 2D hoặc 3D – để xác định vị trí, tư thế, và danh tính của vật thể, sau đó chuyển đổi thông tin này thành các lệnh tọa độ điều khiển, hướng dẫn robot thực hiện thao tác chính xác. Mô hình hoạt động chung của hệ thống Thị giác – Robot:

- Thu nhận hình ảnh (Image Acquisition): Camera (thường được gắn trên đầu kẹp (end-effector) của robot hoặc gắn cố định trên dây chuyền) chụp ảnh vật thể. Đây là nguồn dữ liệu đầu vào.

- Xử lý & Phân tích hình ảnh (Image Processing & Analysis): Hình ảnh thô được đưa qua Bộ xử lý Thị giác (Vision Controller) hoặc một máy tính công nghiệp. Tại đây, các thuật toán (có thể là thuật toán truyền thống hoặc học sâu) được sử dụng để xác định vị trí của vật thể và lớp của nó.

- Tính toán biến đổi tọa độ (Coordinate Transformation): Đây là bước then chốt nhất. Thông tin tọa độ của vật thể trong hệ quy chiếu của camera (Camera Frame) phải được chuyển đổi thành tọa độ trong hệ quy chiếu của robot (Robot Base Frame). Quá trình này được gọi là Hiệu chuẩn (Calibration), đặc biệt là Hiệu chuẩn Tay-Mắt (Hand-Eye Calibration).

- Truyền lệnh và Hành động (Robot Command and Action): Lệnh tọa độ cuối cùng, thường ở dạng 6 bậc tự do (6DOF: x,y,z, roll, pitch, yaw) được gửi qua các giao thức truyền thông công nghiệp (như Ethernet/IP, Profinet, hoặc TCP/IP) tới bộ điều khiển robot. Robot sau đó di chuyển đến vị trí đã tính toán để thực hiện tác vụ (gắp, đặt, hàn…).

Các thành phần kỹ thuật cơ bản của hệ thống Robot Guidance bao gồm: Camera (2D/3D) – thiết bị cảm biến; Bộ xử lý hình ảnh (Vision Controller) hoặc máy tính công nghiệp (IPC) – nơi chạy các thuật toán Machine Vision; và Giao thức truyền thông công nghiệp (Fieldbus Protocols) – đảm bảo lệnh được truyền nhanh chóng và tin cậy.

3. Các Công nghệ Thị giác cốt lõi cho Điều khiển Robot

Sự lựa chọn giữa thị giác 2D và 3D là yếu tố quyết định đối với độ phức tạp và khả năng ứng dụng của hệ thống thị giác máy trong điều khiển robot (robot guidance).

3.1. Thị giác 2D: Tối ưu hóa Tốc độ và Sự đơn giản

Thị giác 2D sử dụng camera thông thường để chụp ảnh mặt phẳng (X,Y) của vật thể. Nó là giải pháp kinh tế và nhanh chóng nhất.

Ưu điểm và Ứng dụng điển hình: Thị giác 2D có tốc độ xử lý nhanh, chi phí phần cứng thấp, và lý tưởng cho các tác vụ Pick & Place các vật thể phẳng, có kích thước ổn định và độ tương phản cao (ví dụ: gắp chip, gắp nhãn mác, gắp sản phẩm được đặt trên băng tải với vị trí Z cố định).

Các kỹ thuật 2D tiên tiến:

- Phát hiện hình học (Geometric Pattern Matching): Thuật toán này tìm kiếm các đặc trưng hình học độc nhất của đối tượng (ví dụ: các đường tròn, góc, đường thẳng) và so khớp chúng với một mẫu đã học. Nó hoạt động tốt ngay cả khi đối tượng bị xoay hoặc thay đổi kích thước nhẹ.

- Định vị dựa trên cạnh (Edge-based Localization): Tập trung vào việc phát hiện và sử dụng các cạnh sắc nét của vật thể để xác định vị trí. Kỹ thuật này ít bị ảnh hưởng bởi sự thay đổi ánh sáng so với các kỹ thuật dựa trên pixel.

Hạn chế: Hạn chế lớn nhất của thị giác 2D là không thể xử lý độ sâu (Z-axis) và hoàn toàn thất bại khi gặp tình huống vật thể xếp chồng (Occlusion) hoặc nằm ngẫu nhiên trong thùng chứa (Random Bin Picking). Trong trường hợp này, robot sẽ không biết phải gắp vật thể nào và gắp ở độ sâu nào.

3.2. Thị giác 3D: Chìa khóa cho Sự linh hoạt và Phức tạp

Thị giác 3D là công nghệ bắt buộc đối với các ứng dụng Robot Guidance tiên tiến, cung cấp thông tin đầy đủ về không gian (X,Y,Z) và tư thế (Roll, Pitch, Yaw).

Vai trò: Thị giác 3D giúp xác định chính xác 6 bậc tự do (6DOF) của vật thể: 3 thông số vị trí (x,y,z) và 3 thông số định hướng (roll, pitch, yaw). Điều này cho phép robot không chỉ biết vật thể ở đâu mà còn biết nó đang nghiêng theo góc nào, từ đó điều chỉnh bộ phận gắp (gripper) để gắp chính xác.

Các phương pháp thu nhận 3D phổ biến:

- Laser Triangulation (Chiếu tia laser): Chiếu một đường hoặc điểm laser lên bề mặt vật thể. Camera quan sát đường laser này từ một góc khác. Độ dịch chuyển của đường laser trên cảm biến cho phép tính toán độ sâu Z. Thích hợp cho việc quét các vật thể chuyển động trên băng tải với độ chính xác cao (micrometer).

- Structured Light (Ánh sáng cấu trúc): Chiếu một chuỗi các mẫu ánh sáng đã biết (ví dụ: các dải sọc hoặc lưới) lên đối tượng. Sự biến dạng của các mẫu ánh sáng khi chúng chạm vào bề mặt vật thể được camera ghi lại và dùng để xây dựng đám mây điểm (Point Cloud) 3D chi tiết. Đây là phương pháp phổ biến nhất cho các tác vụ Bin Picking tĩnh.

- Stereo Vision (Thị giác lập thể): Mô phỏng cách mắt người nhìn. Hệ thống sử dụng hai camera 2D được đặt cách nhau một khoảng cách cố định (Baseline). Bằng cách so khớp các điểm đặc trưng trong cả hai hình ảnh và áp dụng nguyên tắc lượng giác, hệ thống có thể tính toán độ sâu Z của mỗi điểm. Phương pháp này hoạt động tốt trong môi trường sáng và có thể thu thập dữ liệu màu sắc thực.

Ứng dụng: Thị giác 3D là xương sống của các ứng dụng phức tạp như Bin Picking (Gắp vật thể trong thùng chứa lộn xộn) và Lắp ráp các bộ phận không đồng nhất đòi hỏi robot phải điều chỉnh góc gắp liên tục.

4. Ứng dụng Học sâu (Deep Learning) trong Tác vụ Robot Guidance

Trong khi các thuật toán Machine Vision truyền thống (dựa trên cạnh, hình học) bị hạn chế bởi điều kiện ánh sáng và hình dạng vật thể, Học sâu (Deep Learning) đã giải phóng Robot Guidance khỏi các ràng buộc này.

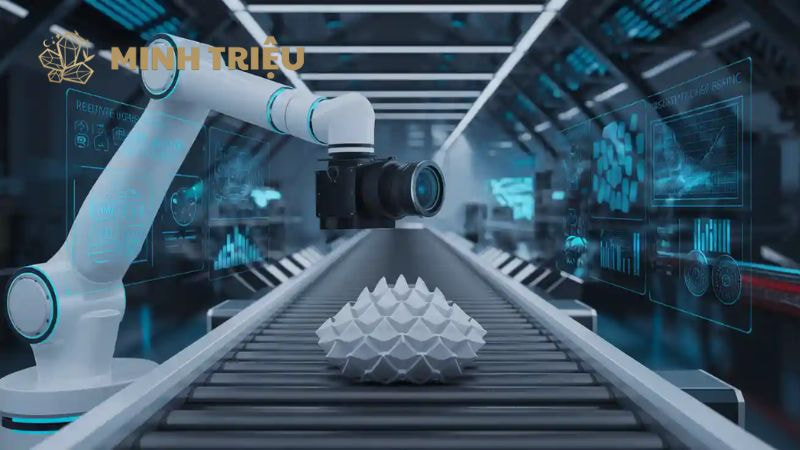

Phát hiện đối tượng (Object Detection) trong Robot Guidance:

- Các kiến trúc như YOLO (You Only Look Once) và Faster R-CNN được sử dụng để xác định vị trí ban đầu của vật thể và phân loại chúng.

- Trong Robot Guidance, tốc độ là tối quan trọng. Các mô hình One-Stage như YOLO được ưu tiên vì tốc độ suy luận (Inference Speed) cực nhanh của chúng, thường đạt 50−100 FPS, cho phép robot phản ứng gần như thời gian thực với các vật thể di chuyển trên băng tải.

- Đối với các ứng dụng yêu cầu độ chính xác định vị cao hơn (ví dụ: lắp ráp), mô hình Two-Stage như Faster R-CNN có thể được sử dụng trong các môi trường có tốc độ xử lý chậm hơn hoặc khi vật thể rất nhỏ.

Ước tính Tư thế đối tượng (Object Pose Estimation): Đây là một bước tiến vượt trội, vượt qua Phát hiện đối tượng chỉ cung cấp Hộp giới hạn 2D. Các mô hình học sâu có khả năng xác định đầy đủ 6DOF của vật thể từ dữ liệu 2D (bằng cách ước tính các điểm mốc 3D) hoặc 3D (phân tích đám mây điểm). Ví dụ, thuật toán PVNet hoặc PoseCNN có thể trực tiếp dự đoán ma trận xoay (Rotation Matrix) và vector tịnh tiến (Translation Vector) cần thiết cho robot. Thông tin này biến thị giác máy trong điều khiển robot (robot guidance) thành một hệ thống dẫn đường hoàn chỉnh.

Phân đoạn ảnh ngữ cảnh (Semantic Segmentation): Mô hình này gán nhãn cho từng pixel trong hình ảnh, phân biệt rõ ràng vật thể cần gắp với nền và với các vật thể khác (ví dụ: khi gắp một dây cáp từ một đống dây cáp khác). Bằng cách tách vật thể ra khỏi sự lộn xộn (Clutter), Phân đoạn ảnh ngữ cảnh cải thiện độ chính xác định vị lên mức tuyệt đối, đặc biệt quan trọng trong các tác vụ Bin Picking phức tạp.

5. Các Ứng dụng Thực tiễn và Lợi ích Đột phá trong Sản xuất Công nghiệp

Thị giác máy trong điều khiển robot (robot guidance) đã tạo ra một cuộc cách mạng trong các tác vụ sản xuất truyền thống, mang lại độ chính xác và tốc độ chưa từng có.

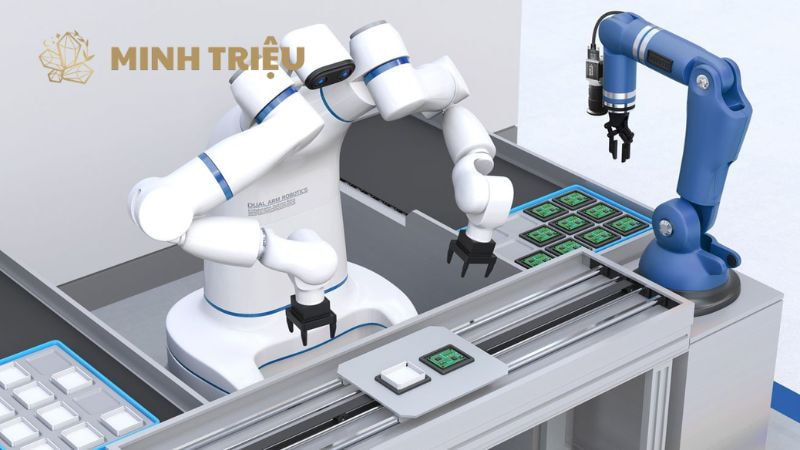

- Robot Pick & Place (Gắp và Đặt): Đây là ứng dụng phổ biến nhất, từ gắp linh kiện điện tử siêu nhỏ đến các vật dụng lớn. Robot được hướng dẫn để gắp linh kiện từ vị trí ngẫu nhiên trên băng chuyền. Nhờ thị giác máy, robot có thể thích nghi ngay lập tức với sự thay đổi vị trí, loại bỏ nhu cầu về các cơ cấu cơ khí đắt tiền để căn chỉnh vật thể. Đặc biệt, Bin Picking (gắp từ thùng chứa) dựa trên thị giác 3D là điển hình cho sự linh hoạt, cho phép robot xử lý hàng hóa nằm lộn xộn.

- Lắp ráp và Đặt chính xác (Precision Insertion/Assembly): Đây là nơi Robot Guidance thể hiện ưu thế vượt trội của mình. Nhiều tác vụ lắp ráp yêu cầu độ chính xác dưới 50 micron (nhỏ hơn sợi tóc). Thị giác máy trong điều khiển robot (robot guidance) (thường là Camera Gắn Tay) sẽ chụp ảnh gần điểm lắp ráp để định vị chính xác vị trí của lỗ và của chi tiết đang được cầm, sau đó điều chỉnh hành trình của robot ở vòng lặp cuối (Closed-Loop Control) để thực hiện thao tác cắm/vặn xoắn mà không gây kẹt hoặc hỏng hóc.

- Hàn tự động (Automated Welding): Trong ngành công nghiệp ô tô hoặc chế tạo máy bay, phôi hàn thường bị biến dạng do nhiệt độ hoặc lỗi gia công. Robot Guidance sử dụng camera để theo dõi đường hàn theo thời gian thực. Robot sẽ liên tục điều chỉnh đường đi của mỏ hàn để bám sát mối nối, đảm bảo chất lượng đường hàn đồng nhất ngay cả khi các bộ phận không nằm ở vị trí lý tưởng. Điều này giúp giảm đáng kể lỗi và nhu cầu can thiệp thủ công.

- Xếp/Dỡ Pallet Ngẫu nhiên (Random Palletizing/Depalletizing): Trong kho bãi, các kiện hàng thường có kích thước, hình dạng, và vị trí ngẫu nhiên. Thị giác máy 3D quét toàn bộ chồng hàng trên pallet để tạo ra mô hình 3D, từ đó xác định thứ tự gắp tối ưu và hướng gắp cho từng hộp, bất kể chúng bị lệch hay nghiêng. Điều này nâng cao khả năng tự động hóa và thông lượng của logistics nội bộ.

6. Xu hướng Phát triển và Tương lai của Công nghệ Robot Guidance

Tương lai của thị giác máy trong điều khiển robot (robot guidance) hướng tới sự tự chủ, linh hoạt và cộng tác.

- Thị giác cho Robot Cộng tác (Cobots): Cobots (Collaborative Robots) làm việc trực tiếp với con người. Thị giác máy là yếu tố an toàn chính, liên tục giám sát khu vực làm việc để phát hiện con người hoặc các vật cản bất ngờ, đảm bảo robot giảm tốc độ hoặc dừng ngay lập tức. Thị giác cũng giúp Cobots học các hành vi phức tạp thông qua các phương pháp dạy học bằng cách quan sát (Learning by Demonstration).

- Thị giác di động (Mobile Vision): Kết hợp Thị giác máy với công nghệ SLAM (Simultaneous Localization and Mapping) cho robot tự hành (AGVs/AMRs). Robot không chỉ thấy vật thể cần gắp mà còn hiểu được bản thân nó đang ở đâu trong không gian nhà máy, tạo ra một bản đồ 3D thời gian thực để điều hướng và tránh chướng ngại vật một cách tự chủ.

- Học Tăng cường (Reinforcement Learning – RL): Thay vì lập trình rõ ràng từng bước, RL cho phép robot tự học cách thực hiện các thao tác phức tạp (như gắp vật thể có hình dạng chưa từng thấy) thông qua thử và sai trong môi trường mô phỏng (Simulation). Thị giác máy cung cấp phản hồi về trạng thái môi trường, là đầu vào thiết yếu cho quá trình Học Tăng cường, tạo ra một thế hệ robot thực sự tự chủ.

7. Kết luận

Thị giác máy trong điều khiển robot (robot guidance) là công nghệ không thể thiếu để duy trì lợi thế cạnh tranh trong sản xuất công nghiệp hiện đại. Nó là cầu nối mạnh mẽ giữa dữ liệu Machine Vision và hành động vật lý của robot, mang lại khả năng định vị 6DOF chính xác và khả năng thích ứng linh hoạt. Việc làm chủ các công nghệ Thị giác 3D và Học sâu trong Robot Guidance sẽ giúp doanh nghiệp tối ưu hóa quy trình, giảm thiểu lỗi và mở ra cánh cửa cho các ứng dụng tự động hóa chưa từng có.