Điện toán đám mây

Tích hợp dữ liệu từ nhiều nguồn trong môi trường đám mây cho sản xuất công nghiệp

Sự phát triển mạnh mẽ của thiết bị IIoT đang tạo ra lượng Big Data khổng lồ nhưng phân mảnh trong môi trường sản xuất. Tích hợp dữ liệu đám mây (Cloud Data Integration) giúp hợp nhất các nguồn dữ liệu OT và IT thành một kho tri thức thống nhất, hỗ trợ doanh nghiệp chuyển từ phản ứng bị động sang dự đoán chủ động. Giải pháp này là nền tảng cho bảo trì dự đoán (Predictive Maintenance) và tối ưu hiệu suất vận hành tổng thể (OEE). Bài viết sẽ phân tích thách thức, mô hình tích hợp dữ liệu và kiến trúc dữ liệu tối ưu cùng những lợi ích chiến lược mà doanh nghiệp có thể đạt được.

1. Giới Thiệu Tổng Quan về Tích Hợp Dữ Liệu Đám Mây trong Công nghiệp

1.1. Bối cảnh Sản xuất Công nghiệp 4.0 và Sự Bùng nổ Dữ liệu

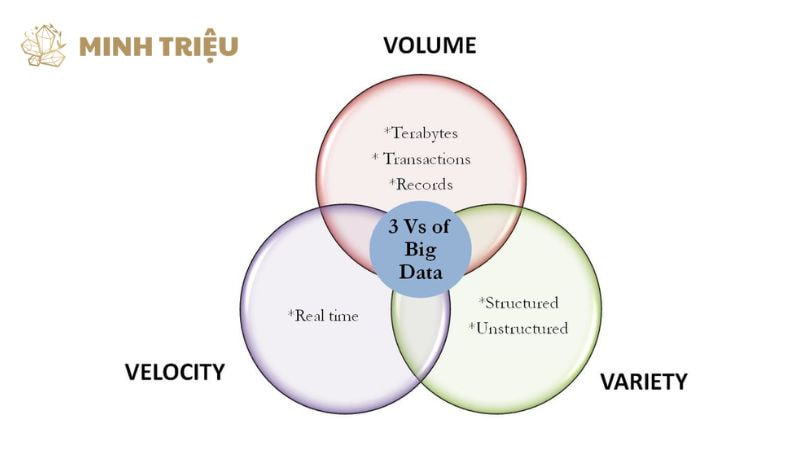

Sản xuất công nghiệp hiện đại dựa trên khả năng thu thập, xử lý và phân tích dữ liệu một cách kịp thời để duy trì lợi thế cạnh tranh toàn cầu. Sự gia tăng cấp số nhân của các thiết bị thông minh, cảm biến và hệ thống IIoT dẫn đến sự bùng nổ khối lượng dữ liệu khổng lồ (Volume) với tốc độ cao (Thời gian thực) và tính đa dạng phức tạp (Variety).

Tuy nhiên, vấn đề cốt lõi mà nhiều doanh nghiệp đang phải đối mặt là sự phân mảnh, khi dữ liệu vẫn bị mắc kẹt trong các silo khác nhau, như hệ thống OT (dữ liệu máy móc, PLC, SCADA) và hệ thống IT (dữ liệu kinh doanh, ERP, MES). Sự cô lập này ngăn cản việc phân tích toàn diện và làm giảm khả năng ra quyết định chiến lược.

1.2. Định nghĩa Tích hợp Dữ liệu Đám mây (Cloud Data Integration)

Tích hợp dữ liệu đám mây là một quá trình công nghệ kết hợp dữ liệu từ nhiều hệ thống nguồn khác nhau, bao gồm các nguồn tại chỗ (on-premise), các ứng dụng đám mây khác, hoặc các nguồn bên ngoài (third-party), vào một kho lưu trữ tập trung trên nền tảng đám mây.

Quá trình này đảm bảo dữ liệu được hợp nhất, làm sạch, và chuẩn hóa xuyên suốt, cung cấp một cái nhìn duy nhất và đáng tin cậy cho các công cụ phân tích. Mục tiêu chính là đảm bảo Chất lượng dữ liệu cao, tính nhất quán (Consistency), và khả năng truy cập dễ dàng, giúp dữ liệu sẵn sàng cho các mô hình AI/ML và ứng dụng Bảo trì dự đoán sau này.

1.3. Lý do Phải Chuyển đổi sang Mô hình Đám mây

Việc chuyển đổi sang mô hình đám mây trở nên cần thiết vì hạ tầng tại chỗ không thể đáp ứng yêu cầu về Khả năng mở rộng và hiệu suất tính toán của Big Data công nghiệp. Data Platform Cloud cung cấp tài nguyên gần như vô hạn, cho phép các nhà sản xuất mở rộng quy mô lưu trữ và xử lý mà không cần đầu tư lớn vào phần cứng (CapEx).

Tính linh hoạt của Cloud thể hiện rõ ở mô hình thanh toán theo nhu cầu (Chi phí vận hành (OpEx)), giúp doanh nghiệp tối ưu hóa chi tiêu và chỉ trả tiền cho những gì họ thực sự sử dụng.

2. Thách Thức Cốt Lõi Khi Tích Hợp Dữ Liệu Rời Rạc

2.1. Khoảng Cách OT/IT (Operational Technology vs. Information Technology)

Khoảng cách giữa OT và IT đại diện cho thách thức kỹ thuật lớn nhất trong việc tích hợp dữ liệu từ nhiều nguồn trong môi trường đám mây công nghiệp. Dữ liệu OT từ các hệ thống điều khiển máy móc (PLC, SCADA) có đặc điểm là độ trễ cực thấp và yêu cầu xử lý Thời gian thực để đảm bảo an toàn vận hành.

Ngược lại, dữ liệu IT từ các hệ thống kinh doanh (ERP, MES) thường là dữ liệu có cấu trúc, được phân tích theo lô (Batch) và không nhạy cảm về thời gian như OT. OT/IT Integration đòi hỏi các giao thức chuyển đổi chuyên biệt (ví dụ: chuyển đổi OPC UA sang MQTT) và các giải pháp Edge Computing để xử lý dữ liệu gần nguồn.

2.2. Vấn đề Khối lượng, Tốc độ và Tính Đa dạng (3Vs of Big Data)

Việc xử lý 3Vs của Big Data là một thách thức mà chỉ có Tích hợp dữ liệu đám mây mới có thể giải quyết được một cách triệt để.

- Volume (Khối lượng): Dữ liệu IIoT có thể đạt hàng Petabyte, đòi hỏi một kho lưu trữ cực lớn như Data Lake.

- Velocity (Tốc độ): Dữ liệu có tốc độ thu thập rất cao, tính bằng hàng nghìn sự kiện mỗi giây, yêu cầu quy trình xử lý luồng (Stream Processing) liên tục để đảm bảo không làm mất dữ liệu quan trọng Thời gian thực.

- Variety (Tính đa dạng): Dữ liệu bao gồm nhiều định dạng khác nhau (dữ liệu cảm biến có cấu trúc, logs phi cấu trúc, hình ảnh/video), đòi hỏi các công cụ ETL/ELT linh hoạt.

Để đối phó với 3Vs này, các nhà sản xuất cần tập trung vào:

- Đảm bảo Khả năng mở rộng của hạ tầng thu thập (Ingestion).

- Sử dụng các công cụ hàng đợi tốc độ cao (Kafka, Kinesis).

- Triển khai các giải pháp nén và lưu trữ dữ liệu hiệu quả.

2.3. Đảm bảo Chất lượng Dữ liệu và Quản trị Dữ liệu (Data Governance)

Quá trình tích hợp dữ liệu gặp phải thách thức nghiêm trọng về việc đảm bảo Chất lượng dữ liệu (Data Quality) và tuân thủ các quy tắc Quản trị Dữ liệu (Data Governance). Dữ liệu thô từ cảm biến thường chứa nhiễu, lỗi truyền tải, hoặc giá trị ngoại lai (outliers), dẫn đến kết quả phân tích sai lệch nếu không được xử lý.

Các bước thiết yếu để đảm bảo Chất lượng dữ liệu trong quá trình tích hợp bao gồm:

- Làm sạch dữ liệu (Data Cleansing): Loại bỏ các bản ghi trùng lặp, giá trị thiếu sót hoặc không hợp lệ.

- Chuẩn hóa dữ liệu (Data Normalization): Đưa các đơn vị đo lường và định dạng khác nhau về một tiêu chuẩn thống nhất.

- Xác thực dữ liệu (Data Validation): Đối chiếu dữ liệu với các quy tắc kinh doanh hoặc các giá trị ngưỡng vật lý.

- Xây dựng Data Lineage: Theo dõi nguồn gốc và hành trình của dữ liệu từ nguồn đến đích cuối cùng, cần thiết cho Phân tích Nguyên nhân Gốc rễ (RCA).

3. Các Mô hình và Công nghệ Tích hợp Dữ liệu Đám mây

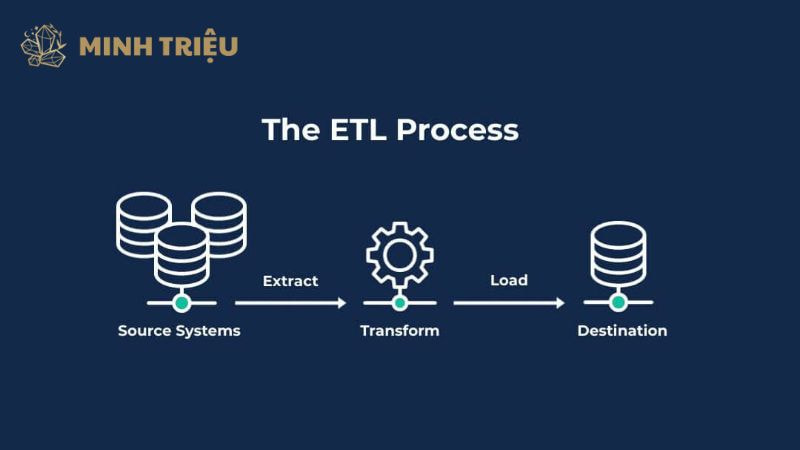

3.1. Mô hình ETL (Extract, Transform, Load) Truyền thống

Mô hình ETL truyền thống mô tả một quy trình trong đó dữ liệu được Extract (trích xuất) từ nguồn, sau đó được Transform (chuyển đổi) trên một máy chủ trung gian, và cuối cùng được Load (tải) vào kho dữ liệu đích. Mô hình này phù hợp cho các hệ thống IT truyền thống (như ERP) với dữ liệu có cấu trúc, nơi các quy tắc chuyển đổi được xác định rõ ràng và không thay đổi thường xuyên.

Tuy nhiên, ETL bộc lộ hạn chế khi đối mặt với Big Data IIoT vì việc chuyển đổi dữ liệu thô cần sức mạnh tính toán lớn và gây ra độ trễ, không đáp ứng được yêu cầu xử lý Thời gian thực.

3.2. Mô hình ELT (Extract, Load, Transform) Hiện đại trên Cloud

Mô hình ELT hiện đại là mô hình tối ưu cho việc tích hợp dữ liệu đám mây và xử lý khối lượng Big Data khổng lồ. Trong ELT, dữ liệu thô được Load (tải) trực tiếp vào một kho lưu trữ đám mây chi phí thấp (Data Lake) trước khi được Transform (chuyển đổi). Mô hình này khai thác triệt để Khả năng mở rộng và sức mạnh tính toán của Cloud, cho phép việc chuyển đổi diễn ra ngay trong Data Lake hoặc Data Warehouse đích.

Ưu điểm nổi bật của ELT là hỗ trợ nguyên tắc Schema-on-read, giúp các nhà phân tích linh hoạt truy vấn dữ liệu thô và tinh chỉnh theo nhu cầu cụ thể của từng bài toán, ví dụ như RCA hoặc Bảo trì dự đoán.

3.3. Tích hợp Dữ liệu Luồng và Change Data Capture (CDC)

Tích hợp Dữ liệu Luồng và CDC là hai kỹ thuật cốt lõi để đảm bảo dữ liệu được cập nhật liên tục và chính xác, cần thiết cho các ứng dụng Thời gian thực. Change Data Capture (CDC) là một kỹ thuật chuyên biệt theo dõi và ghi lại các thay đổi dữ liệu (insert, update, delete) từ cơ sở dữ liệu nguồn (ví dụ: hệ thống MES/ERP) mà không làm ảnh hưởng đến hiệu suất của hệ thống đó. Trong khi đó, Stream Integration sử dụng các dịch vụ hàng đợi tốc độ cao (như Apache Kafka hoặc Amazon Kinesis) để xử lý dòng dữ liệu liên tục từ cảm biến IIoT.

4. Xây dựng Kiến trúc Dữ liệu Đám mây Tối ưu cho Sản xuất

4.1. Vai trò của Data Lake và Data Warehouse

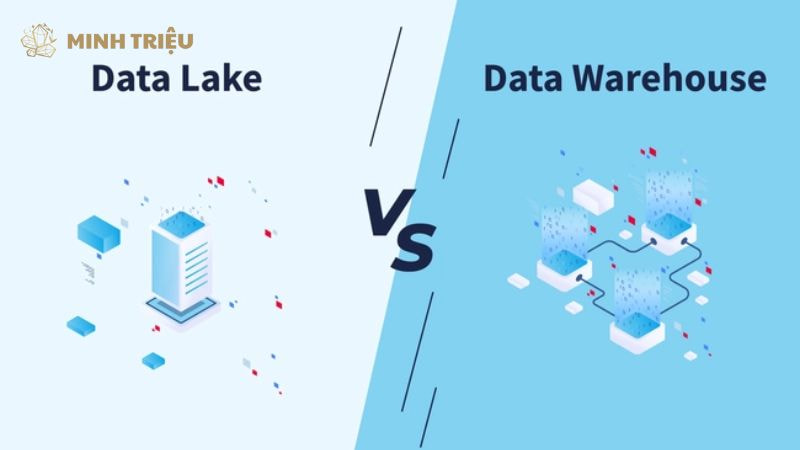

Kiến trúc dữ liệu tối ưu dành cho Sản xuất công nghiệp thường bao gồm sự kết hợp chiến lược giữa Data Lake và Data Warehouse trên nền tảng đám mây. Data Lake đảm nhận vai trò là kho lưu trữ tập trung (single source of truth) và quy mô lớn, có nhiệm vụ giữ lại toàn bộ dữ liệu Big Data thô (logs, dữ liệu cảm biến IIoT) ở định dạng gốc, hỗ trợ cho các phân tích khám phá và AI/ML.

Ngược lại, Data Warehouse là một kho lưu trữ dữ liệu đã được tinh chỉnh, có cấu trúc chặt chẽ, tối ưu cho các truy vấn phân tích kinh doanh (BI) phức tạp và báo cáo hiệu suất OEE. Mối quan hệ giữa hai thành phần này là bổ sung cho nhau, đảm bảo cả tính linh hoạt cho khoa học dữ liệu và hiệu quả cho báo cáo quản lý.

4.2. Tích hợp Edge Computing và Cloud (OT/IT Integration)

Edge Computing (Điện toán biên) đóng vai trò là cầu nối vật lý và logic không thể thiếu trong chiến lược OT/IT Integration. Edge Computing thực hiện xử lý dữ liệu thô ban đầu gần nguồn (tại nhà máy), giúp giảm độ trễ (latency) và băng thông mạng bằng cách chỉ gửi dữ liệu đã được tổng hợp, lọc nhiễu lên Cloud.

Vai trò then chốt của Edge là chuyển đổi các giao thức OT độc quyền (như Profinet) thành giao thức Cloud tiêu chuẩn (MQTT hoặc HTTPS). Sự kết hợp này đảm bảo rằng dữ liệu Thời gian thực được truyền tải hiệu quả và an toàn, đồng thời tận dụng được Khả năng mở rộng của Cloud.

4.3. Thiết lập Data Pipeline tự động (ETL/ELT Pipeline)

Việc thiết lập các Data Pipeline tự động là bước then chốt để duy trì luồng dữ liệu liên tục và Chất lượng cao từ nguồn đến đích, thực hiện các quy trình ETL/ELT. Các công cụ Cloud Native Services (AWS Glue, Azure Data Factory, Google Dataflow) được sử dụng để thiết kế và tự động hóa các đường ống này.

Quy trình tự động hóa này bao gồm các chức năng chính:

- Tích hợp liên tục (Continuous Integration): Đảm bảo rằng bất kỳ dữ liệu mới nào phát sinh từ IIoT hoặc ERP đều được đưa vào pipeline ngay lập tức.

- Làm giàu dữ liệu (Data Enrichment): Bổ sung dữ liệu máy móc (OT) bằng dữ liệu kinh doanh (IT), ví dụ: gắn số lô hàng và tên nhà cung cấp vào các sự kiện cảm biến.

- Giám sát tự động: Theo dõi hiệu suất pipeline và cảnh báo nếu có bất kỳ sự cố nào ảnh hưởng đến Chất lượng dữ liệu hoặc độ trễ Thời gian thực.

5. Kết Luận

Tích hợp dữ liệu từ nhiều nguồn trong môi trường đám mây là xương sống và một nhiệm vụ chiến lược không thể thương lượng của mọi nỗ lực Sản xuất Thông minh. Việc áp dụng Kiến trúc dữ liệu dựa trên Cloud đã thành công giải quyết các thách thức cố hữu về Khả năng mở rộng, Thời gian thực, và khoảng cách OT/IT Integration. Tích hợp dữ liệu đám mây giúp doanh nghiệp chuyển đổi Big Data phân mảnh thành lợi thế cạnh tranh có thể hành động, củng cố hiệu suất OEE và Chất lượng dữ liệu trên toàn bộ quy trình.