Điện toán đám mây

Xây dựng Data Lake/Data Warehouse trên đám mây

Nền tảng Điện toán đám mây đã trở thành động lực cốt lõi thúc đẩy Sản xuất Thông minh bằng cách cung cấp giải pháp vượt trội để quản lý khối lượng Big Data khổng lồ phát sinh từ các quy trình công nghiệp. Việc xây dựng Data Lake/Data Warehouse trên đám mây cung cấp cho doanh nghiệp một Kiến trúc dữ liệu thống nhất, nơi dữ liệu thô và dữ liệu đã được tinh chỉnh hội tụ để hỗ trợ các phân tích nâng cao, Thời gian thực, và các ứng dụng AI/ML. Chiến lược này là chìa khóa để khai thác tối đa giá trị dữ liệu, biến chúng thành lợi thế cạnh tranh trong kỷ nguyên Chuyển đổi số đang diễn ra mạnh mẽ trên toàn cầu. Các công ty cần phải nắm bắt công nghệ này để duy trì vị thế dẫn đầu.

1. Giới thiệu: Tầm quan trọng của Dữ liệu trong Sản xuất 4.0

Trong bối cảnh Sản xuất 4.0 và cuộc cách mạng công nghiệp thứ tư, dữ liệu đã xác lập vai trò là tài sản chiến lược quan trọng nhất của doanh nghiệp công nghiệp, thay thế vai trò của tài nguyên truyền thống như vốn hay nhân công. Sự tích hợp mạnh mẽ của các công nghệ cốt lõi như IIoT, hệ thống cảm biến thông minh, và các hệ thống điều khiển tự động đang tạo ra một “cơn lũ” thông tin chưa từng có, gây áp lực lớn lên Kiến trúc dữ liệu truyền thống tại chỗ (On-premise) vốn khó lòng xử lý hiệu quả.

Nền tảng dữ liệu hiện đại, đặc biệt là trên Điện toán đám mây, là cần thiết để chuyển đổi lượng dữ liệu thô phân mảnh này thành tri thức hành động được, giúp các nhà quản lý đưa ra các quyết định sáng suốt. Việc chuyển đổi này đòi hỏi sự thay đổi tư duy từ quản lý cơ sở hạ tầng sang tập trung vào giá trị dữ liệu.

1.1. Nhu cầu phân tích Big Data và Thời gian thực trong Công nghiệp

Hoạt động Sản xuất công nghiệp hiện đại đang phải đối mặt với các đặc tính 3V của Big Data – Volume (Khối lượng), Velocity (Tốc độ) và Variety (Đa dạng) – bao gồm dữ liệu luồng tốc độ cao từ hàng triệu cảm biến nhiệt độ, áp suất, độ rung, nhật ký máy móc (SCADA, MES), và dữ liệu giao dịch phức tạp từ hệ thống ERP. Khối lượng dữ liệu này đòi hỏi khả năng lưu trữ và tính toán gần như vô hạn và sức mạnh xử lý linh hoạt để thực hiện phân tích Thời gian thực một cách tức thì.

Nhu cầu về phân tích Thời gian thực trở nên cấp thiết trong các lĩnh vực như kiểm soát chất lượng tự động và giám sát an toàn, nhằm mục đích phục vụ các quyết định nhanh chóng như kích hoạt bảo trì dự đoán, phát hiện lỗi sản phẩm tức thì với độ trễ tối thiểu, và tối ưu hóa năng suất dây chuyền sản xuất. Sự chậm trễ có thể dẫn đến thiệt hại kinh tế đáng kể hoặc nguy cơ mất an toàn.

1.2. Vai trò của Cloud Data Platform trong Chuyển đổi số

Cloud Data Platform đóng vai trò là trung tâm hợp nhất dữ liệu trung tâm, giúp doanh nghiệp hòa trộn dữ liệu OT (Operational Technology) từ các hệ thống điều khiển nhà máy với dữ liệu IT (Information Technology) từ các hệ thống kinh doanh một cách liền mạch và có cấu trúc. Sự kết hợp này cho phép tạo ra một cái nhìn 360 độ về hoạt động kinh doanh và sản xuất. Việc triển khai Data Lake/Data Warehouse trên Điện toán đám mây mang lại lợi ích vượt trội về Khả năng mở rộng đàn hồi (elasticity) và hiệu quả chi phí so với việc duy trì hạ tầng tại chỗ cồng kềnh và đắt đỏ.

Chiến lược này đảm bảo nền tảng vững chắc cho lộ trình Chuyển đổi số, hỗ trợ triển khai các dự án AI/ML quy mô lớn, toàn cầu hóa Quản lý chuỗi cung ứng, và thúc đẩy sự ra đời của Sản xuất Thông minh tối ưu.

2. Định nghĩa và Phân biệt Cấu trúc Dữ liệu

Để xây dựng Data Lake/Data Warehouse trên đám mây thành công, doanh nghiệp cần hiểu rõ sự khác biệt cốt lõi về chức năng và Kiến trúc dữ liệu của Data Lake và Data Warehouse, cũng như cách chúng bổ sung cho nhau trong mô hình Lakehouse hiện đại. Hai thành phần này hoạt động bổ sung cho nhau, tạo nên một hệ thống xử lý dữ liệu hoàn chỉnh.

2.1. Data Lake (Hồ dữ liệu): Chức năng và Đặc điểm

Data Lake là một kho lưu trữ tập trung, cho phép doanh nghiệp lưu giữ tất cả dữ liệu thô ở định dạng gốc, duy trì giá trị nguyên thủy của thông tin. Dữ liệu này bao gồm dữ liệu có cấu trúc (từ cơ sở dữ liệu), bán cấu trúc (từ JSON, XML), và phi cấu trúc (từ hình ảnh, video, âm thanh).

Đặc điểm quan trọng nhất của Data Lake chính là nguyên tắc Schema-on-read, nghĩa là cấu trúc (schema) của dữ liệu chỉ được xác định và áp dụng khi dữ liệu được truy vấn hoặc đọc để phân tích, chứ không phải lúc ghi vào. Data Lake đặc biệt phù hợp cho việc lưu trữ các khối lượng Big Data lớn một cách tiết kiệm, hỗ trợ các dự án AI/ML đòi hỏi dữ liệu thô để huấn luyện mô hình, và phục vụ cho phân tích thăm dò (exploratory analysis) mà không cần chuyển đổi trước.

2.2. Data Warehouse (Kho dữ liệu): Chức năng và Đặc điểm

Data Warehouse là một hệ thống được thiết kế để lưu trữ dữ liệu đã được xử lý, làm sạch, và tổ chức theo mô hình quan hệ (thường là dimensional model: Star/Snowflake schema) nhằm mục đích hỗ trợ các báo cáo kinh doanh (BI) và phân tích lịch sử có độ chính xác cao. Cơ chế hoạt động của Data Warehouse tuân thủ nguyên tắc Schema-on-write, tức là cấu trúc dữ liệu phải được xác định rõ ràng, áp dụng, và tuân thủ nghiêm ngặt trước khi dữ liệu được ghi vào kho.

Data Warehouse đảm bảo tính nhất quán, chất lượng dữ liệu cao, và tốc độ truy vấn nhanh, giúp người dùng doanh nghiệp truy vấn dễ dàng và đưa ra các quyết định dựa trên dữ liệu lịch sử đã được kiểm chứng và tổng hợp.

2.3. Bảng so sánh Data Lake và Data Warehouse

Sự khác biệt rõ ràng về Kiến trúc dữ liệu và mục đích sử dụng làm cho hai hệ thống này trở thành bộ đôi không thể thiếu trong môi trường Cloud Data Platform hiện đại, tối ưu hóa cả việc lưu trữ dữ liệu thô và phân tích có cấu trúc.

| Tiêu chí | Data Lake (Hồ dữ liệu) | Data Warehouse (Kho dữ liệu) |

| Loại Dữ liệu | Tất cả các loại (thô, bán cấu trúc, phi cấu trúc) | Dữ liệu đã xử lý, có cấu trúc (Relational) |

| Giá trị/Mục đích | Khám phá dữ liệu, AI/ML, Phân tích Thời gian thực | Báo cáo BI, Phân tích lịch sử, Tuân thủ |

| Độ trễ | Rất thấp (phân tích luồng) | Cao hơn (phân tích Batch) |

| Chi phí Lưu trữ | Thường rẻ hơn (dùng Object Storage) | Thường đắt hơn (dùng cơ sở dữ liệu tính toán cao) |

| Mức độ linh hoạt | Rất cao, cho phép thay đổi mục đích sử dụng | Thấp, cấu trúc cố định cho mục đích BI |

3. Lợi thế Chiến lược khi Chọn Đám mây

Việc triển khai Kiến trúc dữ liệu phức tạp này trên Điện toán đám mây mang lại những lợi thế chiến lược không thể sánh bằng đối với ngành Sản xuất công nghiệp, giải quyết các hạn chế cố hữu của hạ tầng tại chỗ về Khả năng mở rộng và chi phí.

3.1. Khả năng Mở rộng và Hiệu quả Chi phí

Khả năng mở rộng vô hạn và đàn hồi (elasticity) là lợi thế nổi bật nhất khi xây dựng Data Lake/Data Warehouse trên đám mây. Nền tảng Cloud có thể đáp ứng tức thì với sự tăng trưởng dữ liệu không lường trước được của các thiết bị IIoT/OT (Scale-up/Scale-out vô hạn) mà không cần can thiệp thủ công hoặc dự đoán trước nhu cầu.

Về mặt tài chính, mô hình Pay-as-you-go chuyển đổi Chi phí đầu tư (CapEx) cố định ban đầu vào phần cứng thành Chi phí vận hành (OpEx) linh hoạt, cắt giảm gánh nặng tài chính cho doanh nghiệp. Sự linh hoạt này cho phép doanh nghiệp chỉ trả tiền cho tài nguyên tính toán và lưu trữ đã sử dụng, tối ưu hóa ngân sách cho Chuyển đổi số và tránh lãng phí. Mô hình này cũng hỗ trợ việc thử nghiệm và triển khai các mô hình phân tích mới với rủi ro tài chính thấp hơn.

3.2. Tích hợp Công cụ Hiện đại

Các nhà cung cấp dịch vụ Cloud lớn cung cấp một hệ sinh thái rộng lớn gồm các Cloud Native Services được thiết kế chuyên biệt cho việc xử lý và phân tích dữ liệu quy mô lớn, giúp rút ngắn thời gian triển khai (time-to-market).

Sự tích hợp sâu rộng này giúp doanh nghiệp dễ dàng xây dựng các pipeline dữ liệu phức tạp mà không cần tự phát triển các giải pháp riêng lẻ từ đầu, tăng cường hiệu suất của đội ngũ kỹ sư dữ liệu. Các dịch vụ này thường đi kèm với khả năng serverless, giảm thiểu công việc quản lý hạ tầng cho doanh nghiệp.

Các nền tảng Cloud Data Platform nổi bật bao gồm:

- AWS Redshift: Là một Data Warehouse đám mây được tối ưu hóa cho truy vấn phân tích quy mô petabyte, thường được sử dụng kết hợp với AWS S3 (cho Data Lake) trong Kiến trúc dữ liệu Lakehouse.

- Google BigQuery: Là một Data Warehouse serverless với khả năng truy vấn cực nhanh, rất phù hợp cho việc phân tích Big Data tức thời và xử lý dữ liệu Thời gian thực nhờ kiến trúc phân tán hiệu quả.

- Azure Synapse Analytics: Cung cấp một môi trường thống nhất, kết hợp khả năng của Data Lake, Data Warehouse, và ETL/ELT trong một dịch vụ duy nhất, đơn giản hóa việc quản lý nền tảng.

- Snowflake: Là một Data Warehouse độc lập trên Cloud, nổi bật với Kiến trúc dữ liệu linh hoạt và khả năng tách biệt hoàn toàn tính toán và lưu trữ, mang lại sự linh hoạt về chi phí và hiệu suất.

4. Các Bước Kỹ thuật Xây dựng Data Platform trên Đám mây

Việc xây dựng Data Lake/Data Warehouse trên đám mây đòi hỏi một quy trình kỹ thuật có tổ chức và theo từng giai đoạn, bắt đầu từ việc thu thập dữ liệu thô và kết thúc bằng việc cung cấp các công cụ truy vấn cho người dùng cuối.

4.1. Thu thập Dữ liệu (Ingestion) và Tích hợp OT/IT

Thách thức lớn nhất trong Sản xuất công nghiệp là tích hợp dữ liệu Thời gian thực với độ trễ thấp từ các hệ thống điều khiển công nghiệp (OT – như PLC, SCADA) với dữ liệu giao dịch từ hệ thống kinh doanh (IT – như ERP, MES). Phương pháp thu thập dữ liệu (Ingestion) cần ưu tiên các dịch vụ Cloud Native Services xử lý dữ liệu luồng tốc độ cao để đảm bảo tính Thời gian thực cho các ứng dụng giám sát.

Các dịch vụ này bao gồm Amazon Kinesis, Google Pub/Sub, hoặc Azure Event Hubs/Kafka, giúp thu thập và xử lý các luồng dữ liệu liên tục từ nhà máy. Việc xử lý ban đầu này thường bao gồm việc chuẩn hóa định dạng và nén dữ liệu trước khi lưu vào Data Lake.

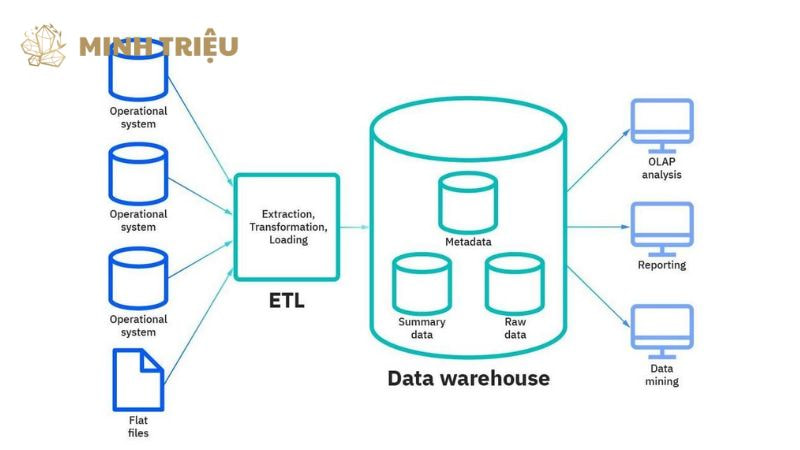

4.2. Xử lý và Chuyển đổi Dữ liệu (ETL/ELT)

Quy trình ETL/ELT (Extract, Transform, Load / Extract, Load, Transform) là bước thiết yếu để làm sạch, chuẩn hóa, và chuyển đổi dữ liệu thô từ Data Lake thành dữ liệu có cấu trúc và đáng tin cậy trong Data Warehouse. Trong Kiến trúc dữ liệu đám mây hiện đại, chiến lược ELT thường được ưu tiên vì nó tận dụng sức mạnh tính toán linh hoạt của Cloud Data Platform để thực hiện việc chuyển đổi (Transform) dữ liệu ngay trên Data Warehouse (ví dụ: AWS Redshift hoặc Google BigQuery), tối ưu hóa chi phí và thời gian xử lý cho các tập dữ liệu lớn.

Các công cụ Cloud Native Services cho ETL/ELT bao gồm AWS Glue (serverless ETL), Google Dataflow (xử lý luồng và hàng loạt), và Azure Data Factory. Việc sử dụng các công cụ này giúp tự động hóa pipeline dữ liệu, đảm bảo chất lượng dữ liệu thông qua các quy tắc kiểm tra nghiêm ngặt, và dễ dàng điều chỉnh logic chuyển đổi theo yêu cầu phân tích mới, đóng góp vào sự linh hoạt của hệ thống.

4.3. Lưu trữ, Cataloging và Truy vấn

Data Lake Storage thường sử dụng các dịch vụ Object Storage chi phí thấp và có độ bền cao (như Amazon S3, Google Cloud Storage – GCS, hoặc Azure Blob Storage) để lưu trữ dữ liệu thô và bán cấu trúc.

Data Cataloging là một thành phần then chốt (ví dụ: AWS Glue Catalog, Google Dataplex), đảm nhận nhiệm vụ lập danh mục (Catalog) cho dữ liệu, giúp người dùng và các công cụ phân tích dễ dàng khám phá vị trí, định dạng, và Schema-on-read của dữ liệu thô trong Data Lake. Các công cụ truy vấn Serverless (như AWS Athena hoặc Google BigQuery) cho phép truy vấn trực tiếp Data Lake Storage mà không cần di chuyển dữ liệu, hỗ trợ phân tích thăm dò nhanh chóng và truy cập vào các tập dữ liệu lịch sử lớn.

5. Đảm bảo Chất lượng và Quản trị Dữ liệu

Khi Kiến trúc dữ liệu trở nên phân tán hơn trên Điện toán đám mây, việc đảm bảo chất lượng, tính bảo mật và tuân thủ các quy định trở nên phức tạp hơn nhưng lại càng quan trọng hơn bao giờ hết, đặc biệt trong môi trường Sản xuất công nghiệp nhạy cảm.

5.1. Quản trị Dữ liệu (Data Governance)

Data Governance là tập hợp các chính sách, quy trình, và vai trò nhằm đảm bảo chất lượng, tính nhất quán, và độ tin cậy của dữ liệu trong toàn bộ môi trường sản xuất số. Trong môi trường Cloud Data Platform, Data Governance bao gồm việc thiết lập metadata chi tiết, xác định lineage (nguồn gốc) của dữ liệu để biết dữ liệu được tạo ra từ đâu (OT hay IT), và áp dụng các chính sách truy cập nghiêm ngặt.

Việc này đảm bảo rằng các mô hình AI/ML và các quyết định dựa trên dữ liệu dẫn đến Sản xuất Thông minh là đáng tin cậy và có thể giải thích được (explainable). Ba trụ cột chính của Data Governance trên Cloud:

- Chất lượng Dữ liệu (Data Quality): Đảm bảo tính chính xác, đầy đủ, và kịp thời của dữ liệu trước khi chuyển vào Data Warehouse.

- Quản lý Metadata (Metadata Management): Tạo danh mục (Catalog) toàn diện và cập nhật liên tục cho tất cả tài sản dữ liệu trong Data Lake.

- Kiểm soát Truy cập (Access Control): Áp dụng các chính sách truy cập dựa trên vai trò (Role-Based Access Control) để bảo vệ thông tin độc quyền và nhạy cảm.

5.2. Bảo mật Dữ liệu và Tuân thủ

Bảo mật dữ liệu là ưu tiên tuyệt đối khi dữ liệu sản xuất quan trọng được lưu trữ trên hạ tầng bên ngoài, đòi hỏi một chiến lược bảo mật đa lớp. Cloud Data Platform yêu cầu áp dụng mã hóa (Encryption) dữ liệu ở cả hai trạng thái: dữ liệu khi truyền tải (in transit, sử dụng TLS/SSL) để ngăn chặn đánh chặn, và dữ liệu khi lưu trữ (at rest, sử dụng mã hóa Object Storage mạnh mẽ).

Các nhà cung cấp Điện toán đám mây cung cấp các dịch vụ quản lý khóa bảo mật (Key Management Services – KMS) chuyên dụng để tăng cường bảo vệ. Về Tuân thủ, doanh nghiệp cần đảm bảo rằng nền tảng Cloud đáp ứng các tiêu chuẩn ngành (ví dụ: ISO 27001, SOC 2) và các quy định pháp lý về chủ quyền dữ liệu (Data Sovereignty) quan trọng cho Sản xuất công nghiệp quốc tế.

6. Kết luận

Xây dựng Data Lake/Data Warehouse trên đám mây là bước đầu tư chiến lược giúp doanh nghiệp sản xuất tiến gần hơn đến Sản xuất Thông minh toàn diện. Nền tảng dữ liệu thống nhất này khai thác tối đa tiềm năng Big Data, hỗ trợ bảo trì dự đoán, tối ưu chuỗi cung ứng và rút ngắn thời gian phát triển sản phẩm mới nhờ AI/ML. Với khả năng mở rộng linh hoạt và chi phí vận hành tối ưu, doanh nghiệp dễ dàng thích ứng và nâng cao năng lực cạnh tranh.