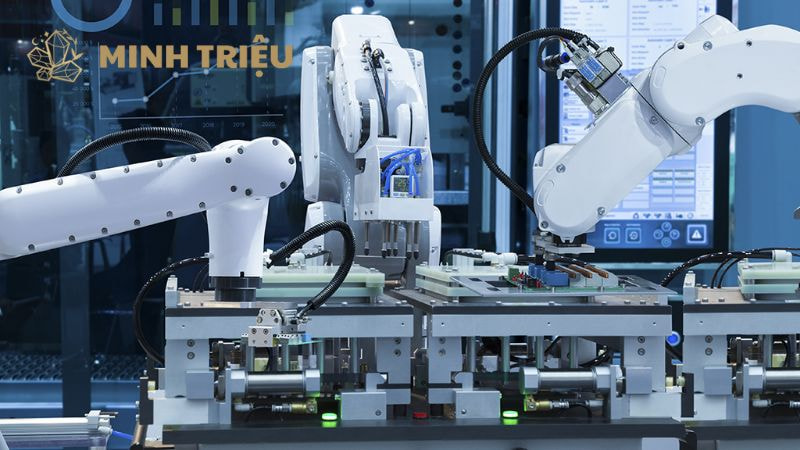

Trí tuệ nhân tạo trong tự động hóa

Vượt Qua Khoảng Cách Sim-to-Real: Chiến Lược Triển Khai Học Tăng Cường Trong Môi Trường Thực Tế Ảo (RL) Cho Sản Xuất

Trí tuệ nhân tạo (AI) đã chứng minh khả năng tối ưu hóa trong môi trường mô phỏng, nhưng việc đưa các mô hình này ra vận hành trên dây chuyền sản xuất thực tế lại là một thách thức hoàn toàn khác. Chiến lược Triển khai học tăng cường trong môi trường thực yêu cầu sự kết hợp nhuần nhuyễn giữa mô phỏng an toàn, thuật toán học hiệu quả và các cơ chế bảo mật nghiêm ngặt. Bài viết này sẽ phân tích các kỹ thuật tiên tiến giúp doanh nghiệp sản xuất vượt qua rào cản Sim-to-Real, khai thác tối đa tiềm năng của Học tăng cường mà vẫn đảm bảo an toàn vận hành.

1. Giới Thiệu: Vai Trò Và Thách Thức Của Học Tăng Cường (RL) Trong Công Nghiệp

1.1. Học Tăng Cường (RL) là gì và tiềm năng trong Tự động hóa

Học tăng cường (Reinforcement Learning – RL) là một nhánh của học máy, nơi một tác nhân (Agent) học cách đưa ra các quyết định tuần tự bằng cách tương tác với môi trường của nó. Quá trình này không dựa vào việc dán nhãn dữ liệu mà thông qua cơ chế thử và sai (trial-and-error), tối đa hóa tổng phần thưởng (rewards) nhận được. Nếu như Học có giám sát (Supervised Learning) giỏi trong việc phân loại, và Học không giám sát (Unsupervised Learning) giỏi trong việc tìm kiếm các cấu trúc ẩn, thì RL là công cụ tối ưu cho các bài toán ra quyết định và điều khiển phức tạp, đặc biệt trong tự động hóa. Trong sản xuất công nghiệp, tiềm năng của RL là vô hạn, vượt xa các thuật toán điều khiển tuyến tính truyền thống:

- Điều khiển Tinh vi: RL có thể học các chiến lược điều khiển phi tuyến tính để giữ cho một hệ thống phức tạp (ví dụ: lò nung, máy ép, dây chuyền robot) hoạt động ở trạng thái tối ưu nhất quán, ngay cả khi điều kiện đầu vào thay đổi.

- Tối ưu hóa Chuỗi Cung ứng Động: Agent RL có thể đưa ra quyết định mua nguyên vật liệu, lập lịch sản xuất và quản lý kho bãi theo thời gian thực để tối đa hóa lợi nhuận hoặc giảm chi phí vận hành, một bài toán tối ưu hóa phức tạp có tính động cao mà các thuật toán tối ưu hóa tĩnh không thể xử lý hiệu quả.

- Cải thiện OEE: Bằng cách tìm ra các tham số vận hành tốt nhất, RL giúp tăng Hiệu suất hoạt động tổng thể (Overall Equipment Effectiveness – OEE) một cách tự động.

Mục tiêu cuối cùng của mọi dự án RL là Triển khai học tăng cường trong môi trường thực, biến lý thuyết tối ưu hóa thành hành động vật lý trên sàn nhà máy.

1.2. Khoảng cách lớn nhất: Từ Mô phỏng đến Thực tế (Sim-to-Real Gap)

Mặc dù RL cho thấy hiệu suất đáng kinh ngạc trong các môi trường mô phỏng hoàn hảo (Simulations), việc đưa các chính sách (Policies) đã học này vào thế giới vật lý lại vấp phải rào cản lớn được gọi là “Khoảng cách Sim-to-Real” (Sim-to-Real Gap). Tại sao không thể triển khai học tăng cường trong môi trường thực một cách trực tiếp?

- Nguy cơ Hỏng hóc và Mất An toàn: Nếu một agent chưa được huấn luyện đầy đủ thực hiện các hành động ngẫu nhiên (Exploration) trên máy móc thực, nó có thể làm hỏng thiết bị đắt tiền, gây thương tích cho nhân viên hoặc làm gián đoạn toàn bộ quy trình sản xuất. Đây là rủi ro không thể chấp nhận được trong công nghiệp.

- Chi phí và Thời gian: Việc thu thập dữ liệu thông qua thử nghiệm vật lý (Physical Trial-and-Error) rất tốn kém và mất thời gian. Một agent có thể cần hàng triệu lần tương tác để học, điều này là bất khả thi trong môi trường sản xuất có giới hạn vật lý.

- Sự khác biệt Vật lý: Mô phỏng không bao giờ hoàn hảo. Có sự khác biệt tinh tế giữa thế giới ảo và thế giới thực về ma sát, độ đàn hồi của vật liệu, độ trễ cảm biến (sensor latency) và nhiễu (noise) mà mô hình đã học trong môi phỏng không tính đến.

Các thách thức cụ thể bao gồm:

- Tính An toàn (Safety): Đảm bảo agent không bao giờ vi phạm các giới hạn vật lý hoặc quy trình đã đặt ra.

- Hiệu quả Mẫu (Sample Efficiency): Giảm thiểu số lượng tương tác cần thiết trong môi trường thực để học được một chính sách tốt.

- Độ trễ (Latency): Đảm bảo hệ thống điều khiển RL có thể phản ứng đủ nhanh để vận hành các thiết bị tốc độ cao.

Việc Triển khai học tăng cường trong môi trường thực thành công đòi hỏi phải có các chiến lược thông minh để “thu hẹp khoảng cách” này.

2. Các Kỹ Thuật Đột Phá Để Bridging Sim-to-Real Gap

Để triển khai học tăng cường trong môi trường thực một cách an toàn và hiệu quả, các kỹ sư phải dựa vào một tập hợp các kỹ thuật tiên tiến nhằm chuyển giao kiến thức từ mô hình đã học trong môi trường ảo sang ứng dụng thực tế.

2.1. Random hóa Miền (Domain Randomization – DR)

Domain Randomization (DR) là một kỹ thuật mạnh mẽ và tương đối đơn giản, được thiết kế để buộc mô hình học tăng cường phải có tính khái quát hóa cao ngay từ đầu. Cơ chế của DR: Thay vì cố gắng tạo ra một mô phỏng hoàn hảo giống hệt môi trường thực, DR lại cố gắng tạo ra một môi trường mô phỏng đa dạng hết mức có thể. Cụ thể, trong quá trình huấn luyện trong mô phỏng, người ta sẽ thay đổi ngẫu nhiên các thông số vật lý và đồ họa của môi trường sau mỗi lần lặp:

- Thông số Vật lý: Thay đổi ngẫu nhiên hệ số ma sát của các bề mặt, khối lượng của các vật thể được robot cầm nắm, độ trễ giả định của cảm biến, hoặc độ cứng của các khớp nối robot.

- Thông số Đồ họa: Thay đổi ngẫu nhiên vị trí, màu sắc, độ sáng của đèn, và texture của môi trường.

Mục đích: Khi agent RL được huấn luyện trên hàng ngàn phiên bản ngẫu nhiên của môi trường, nó buộc phải học một chiến lược điều khiển mạnh mẽ (robust), không phụ thuộc vào một bộ tham số vật lý cụ thể nào. Kết quả là, khi mô hình được Triển khai học tăng cường trong môi trường thực, nơi các tham số vật lý có thể nằm trong phạm vi ngẫu nhiên đã học, mô hình vẫn hoạt động hiệu quả mà không cần tinh chỉnh thêm. DR chuyển thách thức từ việc “tạo mô phỏng hoàn hảo” sang “tạo mô phỏng đa dạng”.

2.2. Học Tăng Cường Ngoại tuyến (Offline/Batch RL)

Học tăng cường truyền thống (Online RL) yêu cầu agent tương tác trực tiếp với môi trường để thu thập dữ liệu (samples). Như đã đề cập, điều này là tốn kém và nguy hiểm trong sản xuất. Học Tăng cường Ngoại tuyến (Offline/Batch RL) đã ra đời để giải quyết vấn đề Hiệu quả Mẫu (Sample Efficiency) và rủi ro an toàn. Cơ chế: Thay vì tương tác mới, Offline RL huấn luyện agent bằng cách sử dụng các bộ dữ liệu lịch sử (log data) khổng lồ đã được thu thập từ các hoạt động sản xuất cũ (ví dụ: dữ liệu vận hành máy móc từ 5 năm qua). Agent học các chính sách tối ưu từ dữ liệu mà không cần tương tác trực tiếp với môi trường thực.

- Lợi ích: Tránh rủi ro thử nghiệm vật lý, giảm nhu cầu về dữ liệu tương tác trong môi trường thực tế, và cho phép sử dụng các bộ dữ liệu lịch sử giá trị.

- Thách thức: Offline RL phải đối mặt với vấn đề “OOD Data” (Out-of-Distribution Data). Agent phải đảm bảo rằng các hành động mới mà nó học được không nằm quá xa so với các hành động đã có trong dữ liệu lịch sử, nếu không sẽ dẫn đến các lỗi không thể sửa chữa.

Các thuật toán như Conservative Q-Learning (CQL) được sử dụng để giải quyết vấn đề này, đảm bảo agent học được một chính sách an toàn, đáng tin cậy dựa trên dữ liệu đã có trước khi Triển khai học tăng cường trong môi trường thực.

2.3. Học Tập Chuyển giao (Transfer Learning) và Tinh chỉnh An toàn

Học tập Chuyển giao là một kỹ thuật linh hoạt, tận dụng tối đa những gì agent đã học được trong môi phỏng và chỉ thực hiện các thay đổi tối thiểu trong môi trường thực. Cơ chế:

- Huấn luyện Cơ bản (Source Domain): Huấn luyện một mô hình RL mạnh mẽ trong môi trường mô phỏng (Source Domain) với Random hóa Miền.

- Chuyển giao và Đóng băng (Transfer): Mô hình đã học được chuyển sang môi trường thực tế (Target Domain). Các lớp mạng thần kinh đầu tiên (thường là các lớp Feature Extraction) được “đóng băng” (Frozen), chỉ cho phép các lớp cuối cùng (Policy Head) được cập nhật.

- Tinh chỉnh An toàn (Safe Fine-tuning): Chỉ thực hiện tinh chỉnh nhỏ (Fine-tuning) bằng một lượng dữ liệu tương tác rất nhỏ trong môi trường thực. Quá trình này được giám sát chặt chẽ và áp dụng các giới hạn an toàn (Safety Constraints) để đảm bảo không có hành động nguy hiểm nào được thực hiện trong khi agent đang học cách thích nghi với các chi tiết vật lý còn thiếu của mô phỏng.

Kỹ thuật này giúp agent nhanh chóng thích ứng với môi trường thực tế mà không cần huấn luyện lại từ đầu, giảm thiểu đáng kể chi phí và rủi ro khi Triển khai học tăng cường trong môi trường thực.

3. Chiến Lược Triển Khai Học Tăng Cường An Toàn (Safe RL)

An toàn là mối quan tâm hàng đầu khi Triển khai học tăng cường trong môi trường thực. Các nhà máy phải tuân thủ các quy tắc an toàn nghiêm ngặt, do đó, các chiến lược Safe RL là bắt buộc.

3.1. Hạn chế An toàn Cụ thể (Safety Constraints)

Safe RL không chỉ tập trung vào việc tối đa hóa phần thưởng (Reward Maximization) mà còn phải đảm bảo rằng chi phí an toàn (Safety Cost) luôn nằm dưới một ngưỡng nhất định. Cơ chế:

- Thiết lập Hàm Phạt (Penalty Functions): Đây là các hình phạt mạnh mẽ được đưa vào hàm mất mát (Loss Function) cho bất kỳ hành vi nào vi phạm giới hạn an toàn. Ví dụ, nếu cánh tay robot cố gắng di chuyển ra khỏi khu vực làm việc cho phép, nó sẽ nhận một hình phạt cực lớn.

- Tối ưu hóa Chính sách Có Ràng buộc (Constrained Policy Optimization – CPO): Đây là một nhóm các thuật toán RL nâng cao được thiết kế để giải quyết các bài toán tối ưu hóa có ràng buộc. CPO đảm bảo rằng agent học cách tối đa hóa phần thưởng nhưng không bao giờ vượt qua một giới hạn chi phí an toàn đã định trước (ví dụ: mô-men xoắn tối đa của động cơ, nhiệt độ tối đa của lò nung). Nếu một hành động mới có nguy cơ vi phạm ràng buộc, thuật toán sẽ không thực hiện hành động đó.

Việc thiết lập các Hạn chế An toàn Cụ thể đòi hỏi sự hợp tác chặt chẽ giữa các nhà khoa học dữ liệu và kỹ sư vận hành để xác định chính xác các ngưỡng vật lý và quy trình không thể vượt qua.

3.2. Điều khiển Mức Độ An Toàn (Trust Region and Exploration)

Trong RL, agent cần khám phá (Exploration) môi trường để tìm ra các chiến lược tối ưu, nhưng trong môi trường thực, việc khám phá ngẫu nhiên có thể dẫn đến thảm họa. Điều khiển Mức Độ An Toàn quản lý sự cân bằng giữa Khám phá và Khai thác (Exploitation) một cách thận trọng. Cơ chế:

- Trust Region Policy Optimization (TRPO/PPO): Các thuật toán này giới hạn mức độ thay đổi của chính sách (Policy) sau mỗi lần cập nhật. Điều này đảm bảo rằng agent không thực hiện những bước nhảy vọt quá lớn trong hành vi của mình. Hành động của agent luôn nằm trong một “Vùng tin cậy” (Trust Region), tức là các hành động đã được chứng minh là an toàn hoặc gần với các hành động an toàn đã biết.

- Giới hạn Khám phá: Khi Triển khai học tăng cường trong môi trường thực, sự khám phá ngẫu nhiên (như Epsilon-Greedy) phải được loại bỏ hoặc thay thế bằng các phương pháp khám phá dựa trên mô hình (Model-Based Exploration), nơi mô hình dự đoán rủi ro trước khi thực hiện hành động, cho phép agent chỉ thực hiện các hành động “đủ an toàn” để khám phá các khu vực chưa biết của không gian trạng thái.

3.3. Vòng lặp Kiểm Soát: Human-in-the-Loop (HITL)

Ngay cả những hệ thống RL an toàn nhất cũng cần một cơ chế dự phòng để Triển khai học tăng cường trong môi trường thực một cách có trách nhiệm. Vòng lặp Kiểm soát có Con người (Human-in-the-Loop – HITL) đóng vai trò là “công tắc khẩn cấp” và “bộ hướng dẫn” trong quá trình học tập. Vai trò của Kỹ sư/Giám sát viên:

- Giám sát và Can thiệp Thời gian thực: Kỹ sư vận hành có khả năng can thiệp hoặc ghi đè hành động của agent ngay lập tức (Override Switch) khi phát hiện nguy cơ không thể lường trước hoặc khi agent đi chệch khỏi mục tiêu sản xuất.

- Hướng dẫn Chính sách (Policy Shaping): Kỹ sư có thể cung cấp phản hồi cho agent (ví dụ: “Đó là một hành động tốt” hoặc “Đừng làm điều đó nữa”) trong quá trình học tập, giúp agent học nhanh hơn và tránh các vùng không an toàn.

- Quy trình Nới lỏng Kiểm soát: Quá trình Triển khai học tăng cường trong môi trường thực phải bắt đầu trong chế độ giám sát chặt chẽ (High Supervision), sau đó từ từ nới lỏng kiểm soát (giảm tần suất can thiệp của con người) khi độ tin cậy và hiệu suất của agent được chứng minh và xác minh qua thời gian dài.

4. Các Trường Hợp Ứng Dụng Thực Tiễn Trong Sản Xuất

Các ví dụ thực tế về Triển khai học tăng cường trong môi trường thực đã chứng minh RL là công cụ thay đổi cuộc chơi trong tự động hóa công nghiệp.

4.1. Điều khiển Robot và Lắp ráp Tinh vi

Lập trình robot truyền thống (Teach Pendant) rất cứng nhắc, không thể thích ứng với sự thay đổi của môi trường (ví dụ: vật thể bị lệch, có hình dạng bất định). RL giải quyết vấn đề này.

- Kịch bản: Dạy robot thực hiện các nhiệm vụ lắp ráp phức tạp, chẳng hạn như cắm các linh kiện điện tử vào một cổng có độ dung sai chặt chẽ, hoặc cầm nắm các vật thể có hình dạng bất định (ví dụ: dây cáp, chi tiết đúc bị lỗi nhỏ).

- Quá trình: Robot được huấn luyện trong mô phỏng (Sim) bằng DR để học các kỹ năng cơ bản, sau đó được Triển khai học tăng cường trong môi trường thực với tinh chỉnh an toàn. Agent học cách sử dụng lực phản hồi (Force Feedback) từ cảm biến để “cảm nhận” môi trường và điều chỉnh chuyển động của mình theo thời gian thực.

- Lợi ích: Giảm thời gian lập trình thủ công từ hàng tuần xuống hàng giờ, tăng tính linh hoạt và khả năng xử lý các tình huống ngoại lệ của robot.

4.2. Tối ưu hóa Tham số Quy trình Công nghiệp

Nhiều quy trình công nghiệp phức tạp dựa vào các tham số điều khiển PID tĩnh hoặc được điều chỉnh thủ công. RL có thể tối ưu hóa các tham số này một cách động.

- Kịch bản: Tối ưu hóa tự động các tham số điều khiển nhiệt độ (ví dụ: lò nung, bể hóa chất), áp suất hoặc tốc độ băng chuyền trong một dây chuyền sản xuất đa biến. Mục tiêu là đạt được chất lượng sản phẩm cao nhất với mức tiêu thụ năng lượng/nguyên liệu thấp nhất.

- Áp dụng RL: Agent nhận trạng thái hệ thống (nhiệt độ hiện tại, tốc độ, chất lượng) và đưa ra hành động thay đổi các tham số điều khiển. Phần thưởng được tính toán dựa trên độ lệch so với mục tiêu chất lượng và mức tiêu thụ năng lượng.

- Lợi ích: Tăng hiệu suất hoạt động tổng thể (OEE) lên tới 5-15%, giảm thiểu lỗi do quá trình điều chỉnh thủ công và thích ứng tự động với sự thay đổi của vật liệu đầu vào.

4.3. Quản lý Năng lượng Thông minh (Smart Energy Management)

Quản lý năng lượng là một bài toán tối ưu hóa lớn và phức tạp trong sản xuất, liên quan đến dự báo tải và giá điện.

- Kịch bản: Sử dụng RL để dự đoán và tối ưu hóa việc sử dụng năng lượng của hệ thống HVAC, máy nén khí, và máy móc công suất lớn, cân bằng giữa nhu cầu sản xuất và chi phí điện năng theo thời gian thực (đặc biệt quan trọng với các biểu giá điện thay đổi).

- Áp dụng RL: Agent RL học cách dự báo nhu cầu sản xuất và giá điện trong 24 giờ tới. Nó quyết định khi nào nên chạy máy nén khí ở công suất cao (khi giá điện thấp) và khi nào nên trì hoãn các tải không thiết yếu (khi giá điện cao), hay thực hiện việc dịch chuyển tải (Load Shifting).

- Lợi ích: Giảm đáng kể chi phí vận hành điện năng và góp phần vào mục tiêu phát triển bền vững của nhà máy. Việc Triển khai học tăng cường trong môi trường thực trong lĩnh vực này mang lại ROI rõ ràng.

5. Thách Thức Kỹ Thuật Khi Đưa RL Vào Sản Xuất

Mặc dù có nhiều thành công, việc Triển khai học tăng cường trong môi trường thực vẫn phải đối mặt với một số rào cản kỹ thuật cần có các giải pháp tiên tiến để khắc phục.

5.1. Hiệu quả Mẫu (Sample Efficiency)

- Vấn đề: RL truyền thống, đặc biệt là Model-Free RL (ví dụ: Deep Q-Networks – DQN, PPO), cần hàng triệu lần tương tác (samples) để học một chính sách tối ưu. Việc tạo ra hàng triệu tương tác vật lý trong môi trường sản xuất là không thể (như đã phân tích ở 1.2).

- Giải pháp:

- Model-Based RL (MBRL): Thay vì học chính sách trực tiếp, MBRL học một mô hình động lực học (Dynamics Model) của môi trường (ví dụ: mô hình dự đoán trạng thái tiếp theo của máy móc). Sau đó, agent sử dụng mô hình này để tạo ra hàng triệu tương tác ảo (Simulated Experiences) một cách nhanh chóng, làm tăng tốc độ học tập và giảm nhu cầu tương tác thực.

- Học từ Dữ liệu Thụ động (Offline RL): Sử dụng triệt để dữ liệu lịch sử vận hành để tiền huấn luyện (Pre-train) agent, giảm đáng kể số lượng mẫu cần thiết trong môi trường thực.

5.2. Quan sát Phần tử (Partial Observability) và Độ trễ

Môi trường công nghiệp thực tế rất phức tạp:

- Quan sát Phần tử (Partial Observability): Cảm biến không thể thu thập mọi thông tin. Nhiễu điện từ, lỗi cảm biến, và độ trễ giao tiếp (Communication Latency) là phổ biến, khiến agent không thể biết được trạng thái “thực” hoàn chỉnh của môi trường.

- Độ trễ: Độ trễ giữa hành động của agent và phản ứng của hệ thống (ví dụ: độ trễ điều khiển van) có thể làm giảm hiệu suất của agent RL.

- Giải pháp: Sử dụng các kiến trúc mạng thần kinh có bộ nhớ như Mạng thần kinh Hồi quy (Recurrent Neural Networks – RNNs), đặc biệt là LSTM (Long Short-Term Memory) hoặc GRU (Gated Recurrent Unit). Các kiến trúc này giúp agent RL xây dựng một “ước tính trạng thái” (State Estimation) nội bộ, hiệu quả ngay cả khi thông tin quan sát được là không hoàn hảo và có nhiễu. Việc này là thiết yếu để Triển khai học tăng cường trong môi trường thực thành công.

5.3. Tính Giải thích (Interpretability) và Kiểm toán

Trong sản xuất, tính minh bạch và khả năng kiểm toán là yêu cầu bắt buộc để tuân thủ các quy định và duy trì niềm tin của kỹ sư vận hành.

- Vấn đề: Các quyết định của agent RL thường là “hộp đen” (Black-box). Khi một robot hoặc hệ thống điều khiển RL đưa ra một hành động bất ngờ (ví dụ: giảm tốc độ sản xuất đột ngột), kỹ sư khó có thể giải thích lý do, gây khó khăn cho việc kiểm toán và khắc phục sự cố.

- Giải pháp: Áp dụng các kỹ thuật Explainable AI (XAI) như LIME hoặc SHAP vào chính sách RL. Các kỹ thuật này có thể làm nổi bật những đặc điểm trạng thái (ví dụ: “Áp suất tăng cao bất thường”) đã dẫn đến quyết định hiện tại của agent. Tính Giải thích là cần thiết để Triển khai học tăng cường trong môi trường thực có thể được các kỹ sư chấp nhận và tin tưởng.

6. Kết Luận

Triển khai học tăng cường trong môi trường thực không còn là tham vọng lý thuyết mà đã trở thành một chiến lược thực tiễn. Nhờ sự phát triển của các kỹ thuật Sim-to-Real như Domain Randomization, Học tăng cường Ngoại tuyến, và đặc biệt là các chiến lược an toàn (Safe RL, HITL), các nhà máy giờ đây có thể khai thác sức mạnh tối ưu hóa của RL mà vẫn bảo vệ được tài sản và quy trình vận hành. Đây chính là chìa khóa để mở khóa một kỷ nguyên tự động hóa thông minh, linh hoạt và an toàn hơn trong công nghiệp 4.0.